-

淘宝dns解析错误导致首页打不开

今天下午3点左右吧, 打开淘宝首页的时候被转到一个错误页面, 说我访问的页面不存在.

看被转过去的页面域名还是err.taobao.com, 所以应该还是淘宝内部的”正常”的跳转, 不是病毒啊什么的.

开tcpdump抓包看一下. 和淘宝有关的记录如下:

192.168.0.110.50874 > 101.226.178.141.80: Flags [.], cksum 0x193e (correct), seq 3469495610:3469497050, ack 3942073739, win 4096, options [nop,nop,TS val 479275520 ecr 780673144], length 1440 D...U\T&..n...E...i.@[email protected]:..E......>..... ..*... xGET / HTTP/1.1 Host: www.taobao.com Connection: keep-alive Accept: text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,*/*;q=0.8 User-Agent: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_10_2) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/41.0.2272.89 Safari/537.36 Accept-Encoding: gzip, deflate, sdch Accept-Language: zh-CN,zh;q=0.8,en;q=0.6 ... 101.226.178.141.80 > 192.168.0.110.50874: Flags [P.], cksum 0x4485 (correct), seq 1:450, ack 1590, win 126, options [nop,nop,TS val 780733766 ecr 479275520], length 449 T&..n.D...U\[email protected]...~D...... F..*.HTTP/1.1 302 Found Server: Tengine Date: Sat, 14 Mar 2015 07:25:11 GMT Content-Type: text/html Content-Length: 258 Connection: keep-alive Location: http://err.taobao.com/error1.html <!DOCTYPE HTML PUBLIC "-//IETF//DTD HTML 2.0//EN"> <html> <head><title>302 Found</title></head> <body bgcolor="white"> <h1>302 Found</h1> <p>The requested resource resides temporarily under a different URI.</p> <hr/>Powered by Tengine</body> </html>总的来说就是我淘宝www.taobao.com, 域名被解析到101.226.178.141这个IP,然后我的请求被转到了http://err.taobao.com/error1.html这个页面.

看一下dns:

% nslookup www.taobao.com 127 ↵ ✭ Server:192.168.0.1 Address:192.168.0.1#53 Non-authori tative answer: Name:www.taobao.com Address: 222.73.134.41 Name:www.ta obao.com Address: 101.226.178.151 Name:www.taobao.com Address: 222.73. 134.51 Name:www.taobao.com Address: 101.226.178.141在 /etc/hosts里添加一行 222.73.134.41 www.taobao.com 指向另外一个IP试一下, 访问正常了. 然后再手工换成101.226.178.141, 还是被转到错误页, 看来101.226.178.141这个IP是有问题.

网上搜索了一下, 101.226.178.141 这个IP是天猫的. 本地看一下:

% host www.tmall.com www.tmall.com is an alias for www.gslb.taobao.com.danuoyi.tbcache.com. www.gslb.taobao.com.danuoyi.tbcache.com has address 101.226.178.111 www.gslb.taobao.com.danuoyi.tbcache.com has address 101.226.178.141 www.gslb.taobao.com.danuoyi.tbcache.com has address 101.226.178.151 www.gslb.taobao.com.danuoyi.tbcache.com has address 101.226.181.111 www.gslb.taobao.com.danuoyi.tbcache.com has address 222.73.134.41 www.gslb.taobao.com.danuoyi.tbcache.com has address 222.73.134.51 www.gslb.taobao.com.danuoyi.tbcache.com has address 101.226.181.101 www.gslb.taobao.com.danuoyi.tbcache.com has address 101.226.178.101所以说, 可能是淘宝DNS管理人员不小心把www.taobao.com的一条IP不小心转到天猫去了. 然后还被电信等dns服务器缓存了起来.

更新: 这其实已经是昨天发生事情了. 但现在看到的dns好像还不对,有可能还是电信的缓存?? 这么久?

到http://tool.chinaz.com/dns 查看了一下, 上海电信的www.taobao.com的dns地址已经没有101.226.178.141了

上海[电信] 101.226.178.151 [上海市 浙江淘宝网络有 限公司电信节点] 101.226.181.101 [上海市 浙江淘宝网络有限公司电信节点] 101.226.178.141 [上海市 浙江淘宝网络有限公司电信节点] 101.226.181.111 [上海市 浙江淘宝网络有限公司电信节点] -

different formatter depends on logging level

Python中记录日志的时候, 希望不同level的日志使用不同的format, 比如INFO以上级别的, 就简单记录一下msg, DEBUG的还要记录一下文件名, 函数名, 行号等信息.

但是翻阅了一下官方文档, 以及搜索了不少资料, 都没能简单的找到答案, 最后一点点线索拼凑出来了我需要的效果.

import logging import logging.handlers import logging.config def initlog(): class MyFormatter(logging.Formatter): def format(self, record): dformatter = '%(levelname)s: [%(asctime)s] - %(pathname)s %(lineno)d - %(message)s' formatter = '%(levelname)s: [%(asctime)s] - %(message)s' if record.levelno <= logging.DEBUG: self._fmt = dformatter else: self._fmt = formatter return super(MyFormatter, self).format(record) config = { "version": 1, "disable_existing_loggers": True, "formatters": { "custom": { '()': MyFormatter, } }, "handlers": { "console": { "class": "logging.StreamHandler", "level": "DEBUG", "formatter": "custom", "stream": "ext://sys.stdout" }, "file_handler": { "class": "logging.handlers.RotatingFileHandler", "level": "DEBUG", "formatter": "custom", "filename": "app.log" } }, 'root': { 'level': level, 'handlers': ['console'] }, "loggers": { "myloger": { "level": level, "handlers": [ "file_handler" ] } } } logging.config.dictConfig(config) initlog() logging.debug("debug") # write to console logger = logging.getLogger("myloger") logger.debug("debug") # write to console and file logger.error("error") # write to console and file如果需要传自定义参数到MyFormatter里面, 可参考

class MyFormatter(logging.Formatter): def __init__(self, args): super(MyFormatter, self).__init__() print args def format(self, record): dformatter = '%(levelname)s: [%(asctime)s] - %(pathname)s %(lineno)d - %(message)s' formatter = '%(levelname)s: [%(asctime)s] - %(message)s' if record.levelno <= logging.DEBUG: self._fmt = dformatter else: self._fmt = formatter return super(MyFormatter, self).format(record) .... "formatters": { "custom": { '()': MyFormatter, 'args': 1 }, .... -

python中的字符串intern机制

intern

python里面, 所有东西都是对象.

a = {"name":"childe"} b = a a is b上面的代码是生成了一个对象, a b 两个变量都指向这个对象.

a = {"name":"childe"} b = {"name":"childe"} a is not b上面的代码是生成了两个对象, a b 两个变量虽然值一样, 但他们是两个不同的对象, 占两块内存.

对于数字有点不一样, python启动的时候, 已经为M以下的小数字预先分配了内存, 因为python认为这些数字是经常被用到的, 频繁的创建和销毁会浪费资源. M的范围是[-5, 257)

字符串又有点不一样

字符串不是python启动时就初始化好的, 是代码中a=“a”的时候时候创建的. 但python会把创建的字符串放在一个缓冲池里面. 之后创建相同字符串的时候, 就会直接返回. 所以x =“a”; y =“a” xy是同一个对象, 也就是 x is y

这就是intern的概念看一下现象

但是对于字符串, 还是遇到了一些”奇怪”的现象.

s1="abcd" s2="abcd" print s1 is s2 s1 ="abc"+"d" s2="ab"+"cd" print s1 is s2 s1 ="a"*20 s2 ="a"*20 print s1 is s2 s1 ="a"*21 s2 ="a"*21 print s1 is s2 s1 =''.join(["abc","d"]) s2 =''.join(["ab","cd"]) print s1 is s2 s1 =''.join(["a"]) s2 =''.join(["a"]) print s1 is s2运行结果

True True True False False Truewhat happened

乍一看, 5段代码, 有时候True 有时候False, 好像很乱, 找不到规律.

字节码

python会把脚本翻译成字节码然后再一条条的执行, 我们看一下上面的代码会翻译成什么字节码?就会发现清楚很多了.

python -m dis phenomena.py第一段给s1 s2赋值的字节码是这样的

4 0 LOAD_CONST 0 ('abcd') 3 STORE_NAME 0 (s1) 5 6 LOAD_CONST 0 ('abcd') 9 STORE_NAME 1 (s2)这个很容易理解, 但实际上第二段第三段代码也是同样的字节码.

也就是说 s1 =”abc”+”d” 和 s1 =”a”*20 这样的代码在编译成字节码的时候已经把右边的值编译出来了.

有点不一样

但是第四段代码并不是这样, 来对比一下看

14 46 LOAD_CONST 12 ('aaaaaaaaaaaaaaaaaaaa') 49 STORE_NAME 0 (s1) 15 52 LOAD_CONST 13 ('aaaaaaaaaaaaaaaaaaaa') 55 STORE_NAME 1 (s2) 19 69 LOAD_CONST 5 ('a') 72 LOAD_CONST 7 (21) 75 BINARY_MULTIPLY 76 STORE_NAME 0 (s1) 20 79 LOAD_CONST 5 ('a') 82 LOAD_CONST 7 (21) 85 BINARY_MULTIPLY 86 STORE_NAME 1 (s2)why

记得经常出现的pyc文件吧, 他们实际上就是存储的编译好的字节码.

“a”20 这样的代码转成”aaaaaaaaaaaaaaaaaaaa”写到字节码的好处显而易见,加快速度,节省内存.

但如果代码里面有个 “a”200000 还编码出来存到pyc, 但pyc就被搞爆掉了, 所以如果字符串长度大于20, 就不会再事先编译好了.runtime

第四,五段代码又有些不一样. ““.join(list) 其实是调用了str的一个方法了, python没有这么牛逼, 直接把方法的执行结果都在编译节段帮我们算出来了, 这个是在runtime执行的. 所以第四段返回了false

长度为1的字符串

第五段代码也是执行了join, 而且在字节码中我们看到和第四段是一样的, 那为什么返回了true呢?

我们来看一下python的代码 http://svn.python.org/projects/python/trunk/Objects/stringobject.c

join生成新的字符串的时候调用了PyString_FromString函数(我看名字猜的TT..), 里面有段代码如下:

if (size == 0) { PyObject *t = (PyObject *)op; PyString_InternInPlace(&t); op = (PyStringObject *)t; nullstring = op; Py_INCREF(op); } else if (size == 1 && str != NULL) { PyObject *t = (PyObject *)op; PyString_InternInPlace(&t); op = (PyStringObject *)t; characters[*str & UCHAR_MAX] = op; Py_INCREF(op); }长度为1的字符串在生成之后会调用PyString_InternInPlace, 这个函数里面实现了intern. 就是到一个全局的字典里面找字符串是不是存在了, 如果已经存在了, 就指过去.

一点困惑

再看一下第一段代码的字节码

4 0 LOAD_CONST 0 ('abcd') 3 STORE_NAME 0 (s1) 5 6 LOAD_CONST 0 ('abcd') 9 STORE_NAME 1 (s2)困惑这两次定义是不是调用了两次PyString_FromString, 如果是的话, 并没有哪里做intern的逻辑. 现在觉得其实是只调用了一次, 至于字节码如何被编译成二进制并运行的, 为什么是只调用了一次, 以后再深究吧.

一个验证的方法就是自己在PyString_FromString中打印一次计数, 然后编译自己的python跑一下.

参考

-

红绿灯

这是什么鬼

有天冲到十字路口, 可是刚刚变成红灯,等了20秒. 接下来还有十几个路口, 就想这次红灯等了20秒, 会不会一连串的红灯把这20秒放大了, 导致到最后耽误了几分钟.有点像蝴蝶效应.

一直感观认为第一个路口耽误的时间会放大, 不知道有没有别人和我一样的第一感?

写了一个程序验证了一下, 因为和第一感不一样, 所以也不确认程序模拟的对不对…

初始化20个红绿灯, 随机红灯时长和绿灯时长. 过马路需要6秒.

两组做为对比, 一个是当前就在第一个路口, 另一个做对比的是20秒后到了第一个路口.

和我之前想的不一样, 迟到的人很快就在下一个路口或者是再下个路口和与另一组的人追平了. 极少极少有时间被放大的情况(以至于我根本没有观察到这种情况)

大规模模拟下来, 平均来看, 在第一个路口晚N秒完全不影响20个路口之后的最终到达时间.

模拟结果

模拟的结果如下, 20个红绿灯, 过马路都是6秒, 结果第一行代表程序开始就在第一个路口, 第二行代表等了一秒才到路口, 20行代表过了20秒才到第一个路口. 考虑到第一个路口之前多出的时间, 最后一行仅比第一行多用了20秒不到(有没有哪里搞错了?)

% python testTrafficLight.py -c 20 -w 6 -f 20 -cmd test 433.329 435.082 436.183 437.105 437.728 438.53 440.029 441.116 441.263 441.538 442.96 443.805 445.111 446.188 448.241 449.592 450.386 451.389 452.043 453.071来看一个具体的例子

“随机”生成5个路口. 假设每个路口都需要6秒. 我们是第0秒就赶到了第一个路口可以马上过红绿灯了. 结果如下:

[[27, 67, 72], [34, 47, 36], [56, 64, 11], [21, 66, 38], [62, 20, 36]] #随机生成的路口 0 [[27, 67, 72], [34, 47, 36], [56, 64, 11], [21, 66, 38], [62, 20, 36]] # 第0秒出现在第1个路口 wait_time: 6 #过马路用了6秒 6 [[27, 67, 78], [34, 47, 42], [56, 64, 17], [21, 66, 44], [62, 20, 42]] # 现在在第二个路口了 wait_time: 6 12 [[27, 67, 84], [34, 47, 48], [56, 64, 23], [21, 66, 50], [62, 20, 48]] wait_time: 39 51 [[27, 67, 29], [34, 47, 6], [56, 64, 62], [21, 66, 2], [62, 20, 5]] wait_time: 25 76 [[27, 67, 54], [34, 47, 31], [56, 64, 87], [21, 66, 27], [62, 20, 30]] wait_time: 38 114“随机”生成和之前一样的5个路口. 同样每个路口都需要6秒. 我们是20秒之后才赶到了第一个路口, 很不巧绿灯不到6秒了, 只能等红灯. 结果如下:

[[27, 67, 72], [34, 47, 36], [56, 64, 11], [21, 66, 38], [62, 20, 36]] #随机生成的路口 20 [[27, 67, 92], [34, 47, 56], [56, 64, 31], [21, 66, 58], [62, 20, 56]] # 20秒后出现在第1个路口 wait_time: 35 #过马路用了35秒 55 [[27, 67, 33], [34, 47, 10], [56, 64, 66], [21, 66, 6], [62, 20, 9]] # 现在在第二个路口了 wait_time: 30 85 [[27, 67, 63], [34, 47, 40], [56, 64, 96], [21, 66, 36], [62, 20, 39]] wait_time: 6 91 [[27, 67, 69], [34, 47, 46], [56, 64, 102], [21, 66, 42], [62, 20, 45]] wait_time: 6 97 [[27, 67, 75], [34, 47, 52], [56, 64, 108], [21, 66, 48], [62, 20, 51]] wait_time: 17 114可以看到第一个人前2个路口都过得很快, 没有等, 只用了12秒. 但在后面3个路口不巧遭遇了红灯, 被第2个人赶上了..

完整代码

#!/usr/bin/env python # -*- coding: utf-8 -*- import random import argparse from copy import deepcopy def init(c, maxred, minred, maxgreen, mingren): lights = [] for i in range(c): green_time = random.randint(minred, maxred) #green_time = 20 red_time = random.randint(mingren, maxgreen) #red_time = 75 light = [green_time, red_time, random.randint(0, green_time+red_time)] lights.append(light) return lights def evaluate(f, w, lights): all_wait_time = f for l in lights: l[-1] = (l[-1]+f) % (sum(l[:2])) for i in range(len(lights)): light = lights[i] if light[-1] < light[0]: # red wait_time = light[0]-light[-1]+w elif light[-1]+w > light[0]+light[1]: #green time is not enough wait_time = light[0]+light[1]-light[-1]+light[0]+w else: wait_time = w all_wait_time += wait_time for l in lights: l[-1] = (l[-1]+wait_time) % (l[0]+l[1]) return all_wait_time def main(): random.seed(1) lights = init( args.c, args.maxred, args.minred, args.maxgreen, args.mingren) print evaluate(args.f, args.w, lights) def test(): s = [0]*args.f for i in range(1000): lights = init( args.c, args.maxred, args.minred, args.maxgreen, args.mingren) for j in range(args.f): all_wait_time = evaluate(j, args.w, deepcopy(lights)) s[j] += all_wait_time for idx,e in enumerate(s): print 1.0*e/1000 if __name__ == '__main__': parser = argparse.ArgumentParser() parser.add_argument("-cmd", default="main") parser.add_argument("-l", default="DEBUG") parser.add_argument( "-c", type=int, default=10, help="how many traffic lights,default 10") parser.add_argument( "-f", type=int, default=10, help="how long should the first light take") parser.add_argument( "-w", type=int, default=5, help="how long should one light take") parser.add_argument("-maxred", type=int, default=75) parser.add_argument("-minred", type=int, default=20) parser.add_argument("-maxgreen", type=int, default=75) parser.add_argument("-mingren", type=int, default=20) args = parser.parse_args() eval(args.cmd)() -

tcp/ip协议学习 第六章 ICMP:Internet控制报文协议

干嘛的

在我看来, ICMP协议主要就是为了互相传递/查询一些基本信息, 大部分是传递一些错误信息.

比如A发送UDP信息到B的10000端口, 但B的10000端口并没有开放, 就会回一个ICMP包给A, 告诉A10000端口未开放.

基本的查询信息, 比如最常用的ping命令, 就是发送ICMP包到目的主机, 然后等待目的主机的响应(响应也是ICMP包).

协议

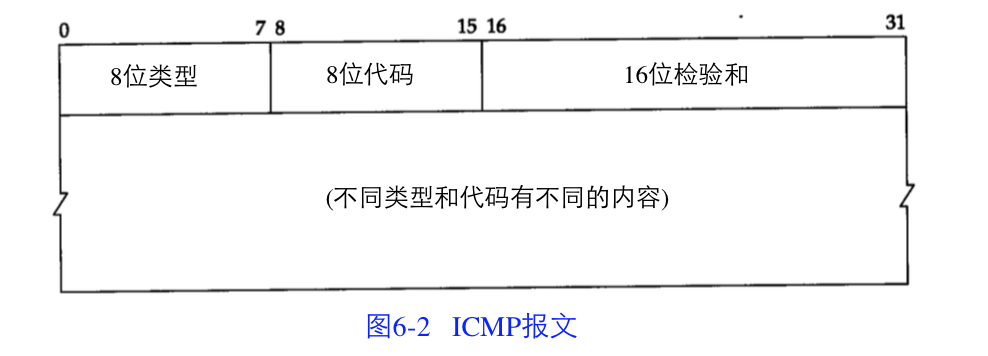

协议定义的非常简单. ICMP在IP层上面一层. 前面是20个字节的IP头, 然后就是ICMP头.

ICMP头, 截图来自TCP/IP协议详解卷一

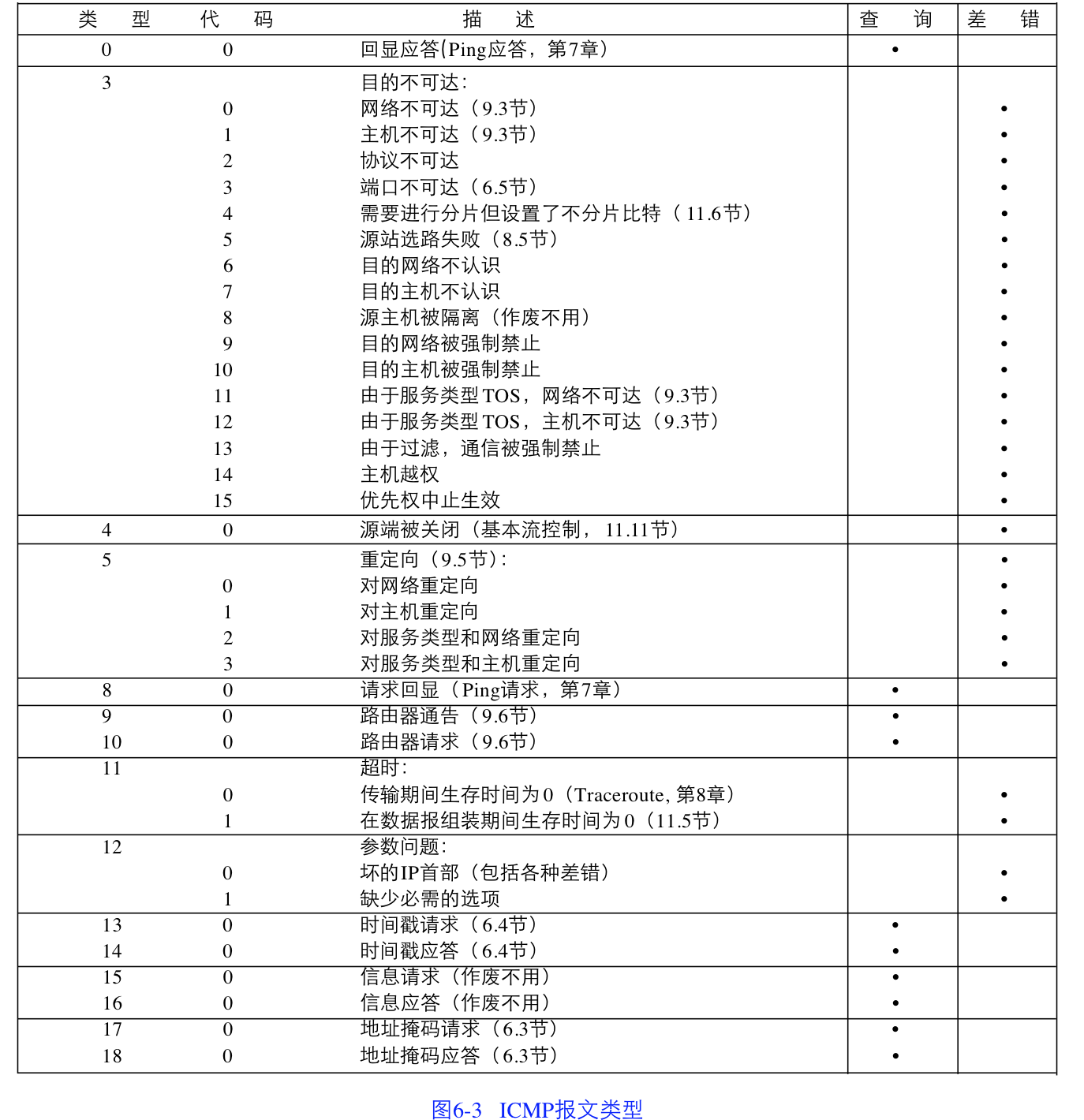

类型和代码两个字段的组合决定了这个ICMP包的用途, 比如我们常用的ping就是0,0组合和8,0组合. 具体如下:

各种类型的ICMP报文, 截图来自TCP/IP协议详解卷一

代码放上

好像没有什么好说的. 直接代码放上吧. 实现了一下书中的例子, 一个是查询子网掩码, 一个是查询时间. github地址, 点我点我

端口不可达

这也是书中的一个例子. 比如A发送UDP信息到B的10000端口, 但B的10000端口并没有开放, 就会回一个ICMP包给A, 告诉A10000端口未开放.

来看一下效果.用瑞士军刀发送个UDP消息到192.168.0.108的10000端口.

% nc -u 192.168.0.108 10000 ✭ abcd同时开一个Tcpdump监听看看:

# tcpdump -vvv -x -nn icmp ✭ tcpdump: listening on eth0, link-type EN10MB (Ethernet), capture size 65535 bytes 01:48:01.420363 IP (tos 0x0, ttl 64, id 45430, offset 0, flags [DF], proto ICMP (1), length 56) 192.168.0.108 > 192.168.0.104: ICMP 192.168.0.108 udp port 10000 unreachable, length 36 IP (tos 0x0, ttl 64, id 42558, offset 0, flags [DF], proto UDP (17), length 33) 192.168.0.104.60181 > 192.168.0.108.10000: [no cksum] UDP, length 5 0x0000: 4500 0038 b176 4000 4001 072a c0a8 006c 0x0010: c0a8 0068 0303 eac9 0000 0000 4500 0021 0x0020: a63e 4000 4011 1269 c0a8 0068 c0a8 006c 0x0030: eb15 2710 000d 0000ping

-

kibana4打包和安装

对于Kibana4,官方只提供了一个打包好的JAVA的包(现在已经是用nodejs了,使用很方便,修改源码也很方便,所以后面这些话忽略吧). 如果想自己修改一些代码添加一些自定义功能, impossible. 至少我还是希望能像Kibana3一样,就是一普通的hmlt静态网站,放在nginx下面跑. 可以添加一些自己的panel. 好吧, 虽然Kibana4好像已经不需要添加什么panel了,但改改css, html总行吧. 而且还可以利用nginx做一些权限控制什么的.

虽然github有源码了,但做为一个新手, 对于grunt这些东西只是有最最最基本的一些了解,还是折腾了一会才搞定. 纪录一下.

以下操作都是基于8cef836c61b5749164156e19accb2a0881e902e4这个commit

-

从github下载kibana4代码.

git clone [email protected]:elasticsearch/kibana.git -

默认你已经有node了, 如果没有, 用apt-get 或者 yum 或者brew等工具装上. 然后先把bower grunt装好, 接下来就要用.

npm install -g bower grunt-cli -

进入kibana目录. 我没有在master分支, 我是切换到了v4.0.0-beta2分支上面.

cd kibana git checkout v4.0.0-beta2 -

安装需要的npm包.

其实, 我不确定是不是所有的包都要装, 我只是要用grunt build一下.甚至只是生成css文件而已.

这里要注意, 如果是用官方源, 而你身在大陆的话, 那就等死吧. 淘宝源在此npm install -

bower install

安装需要的js css包. 从github下载. 对于大陆电信30M用户来说, 也是极其痛苦, 一个400K的包死活就是下载不下来.

osx系统的bower cache文件夹好像在这里/private/var/folders/j9/37cyszz92cg1xkfc46cl5w5r0000gn/T/yourusername/bower 浏览器明明能下载下来, bower就是死活不行. 没办法, 先用浏览器下载之后放在cache文件夹里面bower install - grunt

可以看到默认是跑了两个任务.

grunt.registerTask(‘default’, [‘jshint:source’, ‘less’]); less生成css文件. jshint大概就是检查一下JS语法错误吧.

grunt -

grunt build

其实生成css之后, 把src/kibana放在nginx下面就可以跑了.

build, 就是把一些文件合并压缩一下, 加速用户访问. -

config 配置.

grunt之后, 会在目录下生成一个config文件, 这是一个json文件, 里面是kibana4的一些配置. 里面的kibanaIndex需要改成kibana_index这种格式. 这个生成的原始配置文件应该是nodejs用的, nodejs应该会转成kibana_index这种格式, 但我们现在不用Nodejs做后端服务器了, 所以需要用人改一下.

{ "request_timeout": 60, "kibana_index": ".kibana", "bundled_plugin_ids": [ "plugins/dashboard/index", "plugins/discover/index", "plugins/settings/index", "plugins/table_vis/index", "plugins/vis_types/index", "plugins/visualize/index" ], "default_app_id": "discover", "host": "0.0.0.0", "shard_timeout": 30000, "plugins": [ "plugins/dashboard/index", "plugins/discover/index", "plugins/settings/index", "plugins/table_vis/index", "plugins/vis_types/index", "plugins/visualize/index" ], "port": 5601, "verifySSL": false } -

还差一点点了.

到这里…居然还不行…

打开components/config/config.js, 可以看到:var configFile = JSON.parse(require('text!config')); configFile.elasticsearch = (function () { var a = document.createElement('a'); a.href = 'elasticsearch'; return a.href; }());最重要的elasticsearch的配置, 不是放在配置文件里, 而是写在代码里面了. 这里改成真正的elasticsearch的地址就可以了.

- k4要求ES版本至少也是1.4. 但其实1.3版本的也可以正常使用. 我们就是1.3. 暂时也没打算升级. 限制的代码在index.js里面, 改成

constant('minimumElasticsearchVersion', '1.3.0')就OK了.

OVER.

补充 (曾经的某个版本下还需要):

-

script_fileds

安全起见, 我们的ES禁用script.

但是k4有些请求, 至少在找index pattern的时候, 使用了script_fileds.

我简单粗暴的把components/courier/data_source/_abstract.js里面带script_fileds的代码注释了…

目前还没有发现副作用, 先这样用吧. -

要设置一个默认index pattern

新建index pattern之后, 要设置一个为默认. 否则k4有些2去找名叫.kibana这个index pattern, 当然找不到, 就报错了.

beta2还没这个要求.

我也不是完全确认就是这个原因造成的, 但的确设置一个默认之后就好了.

-

-

tcp/ip协议学习 第四章 ARP:地址解析协议

ARP干嘛的

曾经有段时间, 六七年前了吧. 本科的时候, 流行了一阵子ARP病毒攻击, 导致整个局域网都不能上网了. 当时只听说这个东西防不住, 只要有一个人中毒, 就导致所有人上不了网. 现在也终于知道这是怎么回事了, 也能手工让某个同学上不了网了, 咳咳.

大家应该也都知道ARP是干嘛的, 我再啰嗦一下.. 比如我访问了百度, 百度回了包给我, 百度只知道我的IP是什么,不知道我的MAC地址. 这个包到网关的时候, IP这一层再把数据交给下一层的链路层, 链路层不知道IP是什么东西的, 它只认MAC地址. 所以就需要把IP转成MAC地址, ARP请求就是做这个的.

就是说, 我可以通过这个协议广播问一下所有机器 , 谁的IP是XXX.XXX.XXX.XXX, 请把你的MAC地址告诉我. 这个IP是XXX.XXX.XXX.XXX的机器收到请求之后, 就会告诉我, XXX.XXX.XXX.XXX的MAC地址是啥啥啥.

不幸这个是基于互相信任的, 理论上大家都会相信别人说的是正确的. 但是, 我可以撒谎说, XXX.XXX.XXX.XXX是我, 我的MAC是啥啥啥. 然后本来应该到 XXX.XXX.XXX.XXX那里的数据包就到我这里来了. XXX.XXX.XXX.XXX不仅仅是断网了, 我还能窃听他的数据.

协议格式

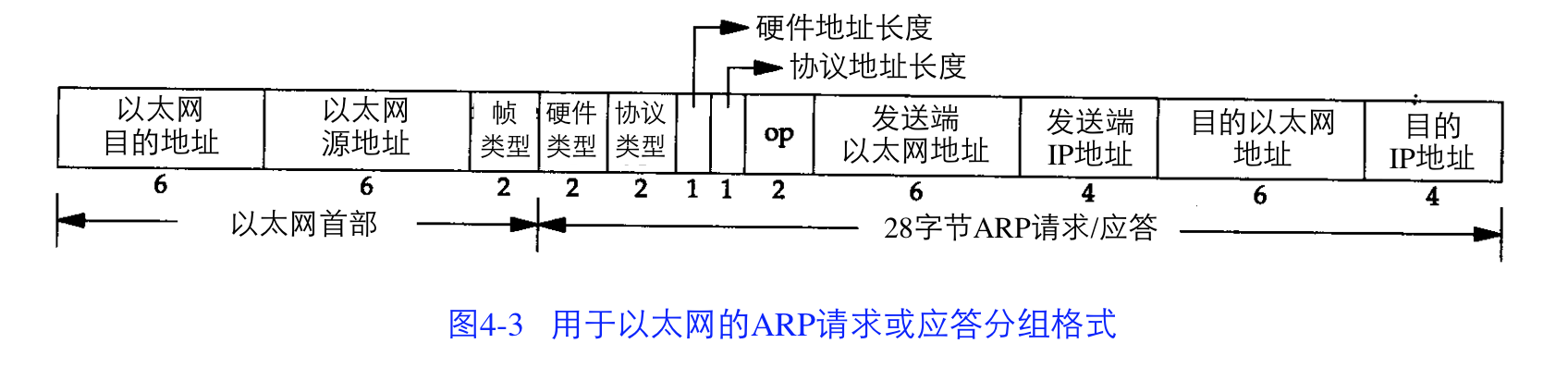

要想伪造, 啊,不, 发送一个ARP请求或者应答, 一定要了解协议格式. 从RFC文件抄了一份.

To communicate mappings from <protocol, address> pairs to 48.bit Ethernet addresses, a packet format that embodies the Address Resolution protocol is needed. The format of the packet follows. Ethernet transmission layer (not necessarily accessible to the user): 48.bit: Ethernet address of destination 48.bit: Ethernet address of sender 16.bit: Protocol type = ether_type$ADDRESS_RESOLUTION Ethernet packet data: 16.bit: (ar$hrd) Hardware address space (e.g., Ethernet, Packet Radio Net.) 16.bit: (ar$pro) Protocol address space. For Ethernet hardware, this is from the set of type fields ether_typ$<protocol>. 8.bit: (ar$hln) byte length of each hardware address 8.bit: (ar$pln) byte length of each protocol address 16.bit: (ar$op) opcode (ares_op$REQUEST | ares_op$REPLY) nbytes: (ar$sha) Hardware address of sender of this packet, n from the ar$hln field. mbytes: (ar$spa) Protocol address of sender of this packet, m from the ar$pln field. nbytes: (ar$tha) Hardware address of target of this packet (if known). mbytes: (ar$tpa) Protocol address of target.这个还是TCP/IP协议详解书里面的图好看一些, 且等我截个图来, 呃,截歪了.

其实里面有些值, 像”硬件地址长度”什么的, 是个变量, 后面的”发送端以太网地址”就是根据这个而变化 .就我们目前的应用和环境来说, 拿这个图就可以啦.

这里的长度单位是字节, 不是上一篇IP协议里面的bit了.详细解释我也copy一下吧. 也是出自TCP/IP协议详解一书.

以太网报头中的前两个字段是以太网的源地址和目的地址。目的地址为全 1的特殊地址是 广播地址。电缆上的所有以太网接口都要接收广播的数据帧。

两个字节长的以太网帧类型表示后面数据的类型。对于 ARP请求或应答来说,该字段的 值为0x0806。

形容词hardware(硬件)和protocol(协议)用来描述 ARP分组中的各个字段。例如,一个 ARP 请求分组询问协议地址(这里是 IP地址)对应的硬件地址(这里是以太网地址)。

硬件类型字段表示硬件地址的类型。它的值为 1即表示以太网地址。协议类型字段表示要 映射的协议地址类型。它的值为 0x0800即表示 IP地址。它的值与包含 IP数据报的以太网数据 帧中的类型字段的值相同,这是有意设计的(参见图 2-1)。

接下来的两个 1字节的字段,硬件地址长度和协议地址长度分别指出硬件地址和协议地址 的长度,以字节为单位。对于以太网上 IP地址的 ARP请求或应答来说,它们的值分别为 6和4。 操作字段指出四种操作类型,它们是 ARP请求(值

(值为3)和RARP应答(值为4)(我们在第5章讨论RARP)。这个字段必需的,因为 ARP请求 和ARP应答的帧类型字段值是相同的。

接下来的四个字段是发送端的硬件地址(在本例中是以太网地址)、发送端的协议地址 (IP地址)、目的端的硬件地址和目的端的协议地址。注意,这里有一些重复信息:在以太网的数据帧报头中和 ARP请求数据帧中都有发送端的硬件地址。

对于一个 ARP请求来说,除目的端硬件地址外的所有其他的字段都有填充值。当系统收到一份目的端为本机的 ARP请求报文后,它就把硬件地址填进去,然后用两个目的端地址分 别替换两个发送端地址,并把操作字段置为 2,最后把它发送回去。

来段程序吧

其它也没啥好说的了, 先来段程序吧.

广播一个ARP请求, 问一下网关的MAC地址是多少. 运行环境是ubuntu12.04. osx上面是不行的. 据说windows也不行. 搜索了好久, 也不知道mac上面怎么搞.

#!/usr/bin/env python # -*- coding: utf-8 -*- ''' 广播一个ARP请求, 问一下网关的MAC地址是多少. 运行环境是ubuntu12.04. osx上面是不行的. 据说windows也不行. 搜索了好久, 也不知道mac上面怎么搞. ''' import socket import struct def main(): st = struct.Struct('!6s 6s h h h b b h 6s 4s 6s 4s') GATEWAY = '192.168.1.1' MYIP = '192.168.1.8' MYMAC = '20:c9:d0:88:96:3f' dst_ethernet_addr = ''.join( [chr (int(e, 16)) for e in 'FF:FF:FF:FF:FF:FF'.split(':')]) protocol_type = 0x0806 hw_addr_space = 1 protocol_addr_space = 0x800 hw_addr_length = 6 protocol_addr_length = 4 op = 1 my_mac = ''.join([chr(int(e, 16)) for e in MYMAC.split(':')]) my_ip = socket.inet_aton(MYIP) target_hw_addr = ''.join( [chr (int(e, 16)) for e in '00:00:00:00:00:00'.split(':')]) des_ip = socket.inet_aton(GATEWAY) data = ( dst_ethernet_addr, my_mac, protocol_type, hw_addr_space, protocol_addr_space, hw_addr_length, protocol_addr_length, op, my_mac, my_ip, target_hw_addr, des_ip, ) packed_data = st.pack(*data) s = socket.socket(socket.PF_PACKET, socket.SOCK_RAW, socket.SOCK_RAW) s.bind(('eth0', socket.SOCK_RAW)) # 下面这样也行, 不知道区别. #http://sock-raw.org/papers/sock_raw 这个应该可以参考 #s = socket.socket(socket.PF_PACKET, socket.SOCK_RAW) #s.bind(('eth0',0)) r = s.send(packed_data) print r return if __name__ == '__main__': main()抓包结果, 这里已经忽略了以太网首部的14个字节. 是从上图中的”硬件类型”开始的.

% sudo tcpdump -nn -vvv -x -c1 arp tcpdump: listening on eth0, link-type EN10MB (Ethernet), capture size 65535 bytes 19:28:43.209235 ARP, Ethernet (len 6), IPv4 (len 4), Request who-has 192.168.1.1 tell 192.168.1.8, length 28 0x0000: 0001 0800 0604 0001 20c9 d088 963f c0a8 0x0010: 0108 0000 0000 0000 c0a8 0101 1 packet captured 1 packet received by filter 0 packets dropped by kernelARP攻击

上面的代码简单改一下就可以做ARP攻击了.

对网关做一个ARP应答.

op改为2, 代表ARP应答. 然后把 “以太网源地址”和”发送端以太网地址”都写自己的. IP地址写要攻击的人. OVER -

tcp/ip协议学习 第三章 IP协议

IP的头文件还是先贴一下, 总是记不住.

0 1 2 3 0 1 2 3 4 5 6 7 8 9 0 1 2 3 4 5 6 7 8 9 0 1 2 3 4 5 6 7 8 9 0 1 +-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+ |Version| IHL |Type of Service| Total Length | +-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+ | Identification |Flags| Fragment Offset | +-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+ | Time to Live | Protocol | Header Checksum | +-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+ | Source Address | +-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+ | Destination Address | +-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+ | Options | Padding | +-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+-+网络和子网划分

不太明白ABCD四类地址划分的意义,除了在路由选择的匹配中会配合子网划分用到.

路由表, 路由选择

以前本科的时候, IP配置好之后, 学校内网是可以访问的. 如果想访问外网, 需要拨号.但拨号之后内网就不方便上了.

学校网站有个小程序, 可以傻瓜式的修改系统路由. 拨号之后内网外网一起上.

当时不明白这是个什么东西, 其实现在也想不太明白怎么回事, 也没条件回学校试验下了. 但至少现在也算大概明白路由表以及路由选择了.

之前为了学习, 拿公司的网络实验了一把. osx下面的双网卡路由配置

来段程序吧

python

用程序发送raw IP包的时候, Total Length 和 Checksum 会由内核自动生成. 至于为啥,可能看到tcpip协议详解下(实现)的时候就知道了吧.

Checksum 算法在模拟后面协议的时候就要自己实现了.ICMP、IGMP、UDP和TCP都采用相同的检验和算法.

有个不同点是: 首部检验和字段是根据IP头计算的检验和码。它不对body进行计算。 ICMP、 IGMP、UDP和TCP的checksum覆盖首部和数据。

#!/usr/bin/env python # -*- coding: utf-8 -*- '''发送一个裸的IP包, 20字节的IP头, 后面跟一个随便写的字符串. 还不知道IP包的ID应该根据什么生成, 就随便写了一个54321 IP头里面: IP包总长度属性和checksum属性都是内核自动生成的. 协议是用的socket.IPPROTO_TCP,也就是6.但没什么用,IP包里面就随便的字符串,不是按TCP协议来的. ''' import socket from struct import pack import sys def main(): try: s = socket.socket(socket.AF_INET, socket.SOCK_RAW, socket.IPPROTO_RAW) except socket.error as msg: print 'Socket could not be created. Error Code : ' + str(msg[0]) + ' Message ' + msg[1] return packet = '' source_ip = '127.0.0.1' dest_ip = '127.0.0.1' # ip header fields ip_ver = 4 ip_ihl = 5 ip_tos = 0 ip_tot_len = 0 # kernel will fill the correct total length ip_id = 54321 ip_frag_off = 0 ip_ttl = 32 ip_proto = socket.IPPROTO_TCP # no use in this case ip_checksum = 0 # kernel will fill the correct checksum ip_saddr = socket.inet_aton(source_ip) ip_daddr = socket.inet_aton(dest_ip) ip_ihl_ver = (ip_ver << 4) + ip_ihl # the ! in the pack format string means network order ip_header = pack( '!BBHHHBBH4s4s', ip_ihl_ver, ip_tos, ip_tot_len, ip_id, ip_frag_off, ip_ttl, ip_proto, ip_checksum, ip_saddr, ip_daddr) user_data = sys.argv[1] if sys.argv[1:] else '0123456789' packet = ip_header + user_data # the port specified has no effect r = s.sendto(packet, (dest_ip, 0)) # result is the length of packet sent out print r if __name__ == '__main__': main() ip_check = 1231 # kernel will fill the correct checksum抓包. 运行环境, ubuntu12.04

% sudo tcpdump -i lo -x -vvv -t -c 1 ✭ tcpdump: listening on lo, link-type EN10MB (Ethernet), capture size 65535 bytes IP (tos 0x0, ttl 32, id 54321, offset 0, flags [none], proto TCP (6), length 30) localhost.12337 > localhost.12851: tcp 10 [bad hdr length 0 - too short, < 20] 0x0000: 4500 001e d431 0000 2006 c8a6 7f00 0001 0x0010: 7f00 0001 3031 3233 3435 3637 3839 1 packet captured 2 packets received by filter 0 packets dropped by kerneltcp 10 [bad hdr length 0 - too short, < 20] 是说IP body里面的字节数太少, 只有10, 小于TCP header应有的20字节.

-

1字节, 45, 4代表Version, 5代表Header Length, 单位是4Byte.

- 2字节, 00, OTS(Type of Service), 代表此IP包的最小时延,最大吞吐量,最高可靠性, 最小费用等特征. 比如用于FTP的控制的IP包, 应该是最小时延, 用于FTP的数据的IP包, 则应该是最大吞吐量.书中提到:

现在大多数的TCP/IP实现都不支持TOS特性,但是自4.3BSD Reno以后的新版系统都对它 进行了设置。另外,新的路由协议如 OSPF和IS-IS都能根据这些字段的值进行路由决策。

-

3,4字节, 001e, Total Length. 0x1e = 30; 发送的01234567890+20字节的IP Header.

因为一些数据链路(如以太网)需要填充一些数据以达到最小长度。尽管以太网的最小帧长为 46字节,但是IP数据可能会更短,像我们就是30。如果没有总长度字段,那么IP层就不知道46字节中有多少是IP数据报的内容。所以IP包总长度这个字段是一定需要的. -

5,6字节, Identification. 0xd431=54321.

-

7,8字节, 0000.

-

9字节, 20. TTL. 路由转发此IP包的时候就把这个数值减1, 减到0的时候就直接丢弃, 并发送ICMP通知主机. trouceroute即利用了这个.

-

10字节, 06, 代表TCP协议.

-

11,12字节 c8a6. Checksum.

-

13-16字节, 7f00 0001. Source Address. 代表127.0.0.1

- 17-20字节, 7f00 0001. Destination Address. 代表127.0.0.1

Checksum是内核帮我们算好的, 但以后的TCP等就要自己算了, 这里先看一下算法.

首先把检验和字段置为 0。然后,对首部中每个 16 bit 进行二进制反码求和(整个首部看成是由一串 16 bit的字组成)

def checksum(ip_header): ip_header += chr(0x00)*(len(ip_header)%2) r = 0 while ip_header: # 因为ip_header已经是网络序了, 所以这里用!H. 否则需要用H r += unpack('H',ip_header[:2])[0] ip_header = ip_header[2:] if r > 0xffff: r = r&0xffff + (r>>16); return ~r -

-

OSX下面的双网卡路由配置

曾经的公司网络

公司网络现在已经好多了, 以前的时候挺奇葩的:无线网络可以连外网, 但不能连公办网络, 有线的正好反过来.

想工作的时候吧,就把无线停了,或者把有线的优先级设高. 遇到问题想google一下呢,就要再反过来把有线停了,无线打开.

有同事说osx设置好有线和无线的优先级,不会有这个问题,系统会自己尝试,测试下来不可以.

当前配置

这种配置下, 只能走有线到办公网络. 不能通过wifi连外网.

无线网卡

% ifconfig en0 en0: flags=8863<UP,BROADCAST,SMART,RUNNING,SIMPLEX,MULTICAST> mtu 1500 ether 20:c9:d0:88:96:4f inet6 fe80::22c9:d0ff:fe88:963f%en0 prefixlen 64 scopeid 0x5 inet 172.16.27.226 netmask 0xfffff800 broadcast 172.16.31.255 nd6 options=1<PERFORMNUD> media: autoselect status: active有线网卡

% ifconfig en2 en2: flags=8963<UP,BROADCAST,SMART,RUNNING,PROMISC,SIMPLEX,MULTICAST> mtu 1500 options=4<VLAN_MTU> ether 00:8a:8d:8a:12:2a inet6 fe80::28a:8dff:fe8a:121a%en2 prefixlen 64 scopeid 0x4 inet 172.16.142.76 netmask 0xffffff00 broadcast 172.16.142.255 nd6 options=1<PERFORMNUD> media: autoselect (100baseTX <full-duplex>) status: active路由表 osx下面要用netstat查路由表

% netstat -rl -f inet Routing tables Internet: Destination Gateway Flags Refs Use Mtu Netif Expire default 172.16.142.251 UGSc 31 0 1500 en2 default 172.16.24.1 UGScI 3 0 1500 en0 127 localhost UCS 0 0 16384 lo0 localhost localhost UH 8 17513401 16384 lo0 169.254 link#4 UCS 0 0 1500 en2 172.16.24/21 link#5 UCS 8 0 1500 en0 172.16.24.1 0:1a:e3:5b:f:d7 UHLWIir 4 43 1500 en0 1119 172.16.142.251 0:1a:e3:5b:1c:44 UHLWIir 32 14 1500 en2 1200先看一下系统是怎么找一个IP包应该走哪个路由的:

IP路由选择主要完成以下这些功能: 1)搜索路由表,寻找能与目的IP地址完全匹配的表目(网络号和主机号都要匹配)。如果 找到,则把报文发送给该表目指定的下一站路由器或直接连接的网络接口(取决于标 志字段的值)。

2)搜索路由表,寻找能与目的网络号相匹配的表目。如果找到,则把报文发送给该表目 指定的下一站路由器或直接连接的网络接口(取决于标志字段的值)。目的网络上的所有主机都可以通过这个表目来处置。例如,一个以太网上的所有主机都是通过这种表目进行寻径的。这种搜索网络的匹配方法必须考虑可能的子网掩码。关于这一点我们在下一节中进行讨论。

3)搜索路由表,寻找标为“默认(default)”的表目。如果找到,则把报文发送给该表目指定的下一站路由器。

from TCP/IP 协议卷1 3.3节

可以看到我这里路由默认走的是有线的, 毕竟在上班, 办公环境要优先, 然后是wifi. 但实际上路由表搜索下来, 除了172.16.24, 其他是不会走到wifi的. 就是说wifi其实是废的.

添加路由

思路就是:

-

把wifi设置成优先的default路由

-

配置内网的网段走有线的网关

-

除了有线的, 自然就是走wifi default了

走起.

-

网络偏好设置里面, 把wifi调整为最高优先级

-

添加路由

route add -net 192.168.0.0/16 172.16.142.251 route add -net 10.0.0.0/8 172.16.142.251就这么简单, 搞定! 来Ping 一下

% ping -c 1 www.baidu.com PING www.a.shifen.com (61.135.169.105): 56 data bytes 64 bytes from 61.135.169.105: icmp_seq=0 ttl=50 time=23.199 ms --- www.a.shifen.com ping statistics --- 1 packets transmitted, 1 packets received, 0.0% packet loss round-trip min/avg/max/stddev = 23.199/23.199/23.199/0.000 ms % ping -c 1 10.8.84.90 64 ↵ PING 10.8.84.90 (10.8.84.90): 56 data bytes 64 bytes from 10.8.84.90: icmp_seq=0 ttl=58 time=1.286 ms --- 10.8.84.90 ping statistics --- 1 packets transmitted, 1 packets received, 0.0% packet loss round-trip min/avg/max/stddev = 1.286/1.286/1.286/0.000 ms赞, 都是通的.

再来一个内网的域名

% ping es.XXXcorp.com ping: cannot resolve es.XXXcorp.com: Unknown host擦, 解析不了域名!

更改DNS

域名解析不了嘛, 肯定是dns的问题. 手动更改一下/etc/resolv.conf嘛. 看一下有线的dns配置, 找到有线的dns服务器加进去.

再来一次!

% ping es.XXXcorp.com ping: cannot resolve es.XXXcorp.com: Unknown host还是不行…

清理一下dns再来一次. 不同版本的osx不一样的命令, 咱保险起见, 都来一次.

dscacheutil -flushcache killall -HUP mDNSResponder还是不行…

nslookup手工指定server是没问题的.

% nslookup > server 192.168.102.20 Default server: 192.168.102.20 Address: 192.168.102.20#53 > es.XXXcorp.com Server: 192.168.102.20 Address: 192.168.102.20#53 Non-authoritative answer: Name: es.XXXcorp.com Address: 10.8.81.10 >总之, 一翻测试下来, 才发现

nslookup, host命令是可以的, ping 浏览器都解析不了.然后又一翻搜索, 原来还要到网络偏好设置里面,去那里改dns才行.

nslookup和浏览器是去不同地方找配置的.做如上修改之后, 整个网络都畅通了.

-

-

python里多线程的写法

今天用到python多线程的时候, 发现不知道如何正确的等待所有线程结束后再结束主线程.

其实到最后我才知道这都是杞人忧天, Thread()出来的实例本来就是等到主进程结束后才结束.

官方解释:

daemon A boolean value indicating whether this thread is a daemon thread (True) or not (False). This must be set before start() is called, otherwise RuntimeError is raised. Its initial value is inherited from the creating thread; the main thread is not a daemon thread and therefore all threads created in the main thread default to daemon = False.

The entire Python program exits when no alive non-daemon threads are left.

默认daemon是false, start之后也不会阻塞在那里(废话, 否则要多线程干嘛, 不过总会想到join会阻塞这点). 对于我的需要来说简直完美,其实什么都不用做嘛.

可以用setDaemon(True)改变daemon值. 这样的话, 就需要调用join等待子线程结束了. (好多此一举..)

for t in threads: t.join()

可以把所有要起的线程放到一个队列里面, 然后对每一个线程join. 这样的确是可以实现, 但看起来太丑, 用着实在别扭.

像如下这样, 其实for循环里面, 进程等待在第一个join那里:

#!/usr/bin/env python # -*- coding: utf-8 -*- from threading import Thread import time def target(i): time.sleep(10-i) def main(): threads = [] for i in range(10): t = Thread(target=target,args=(i,)) threads.append(t) for t in threads: t.start() for idx,t in enumerate(threads): print idx t.join() if __name__ == '__main__': main()multiprocessing.Pool

又用Queue实现了一下, 但还是太丑陋, 封装不好. 然后才搜索到Python其实有个multiprocessing.Pool, 可以很好看的实现这个功能:

#!/usr/bin/env python # -*- coding: utf-8 -*- from multiprocessing import Pool import time def work(): print time.time() time.sleep(4) def main(): pool = Pool(processes=4) for i in range(4): pool.apply_async(work) pool.close() pool.join() if __name__ == '__main__': main()借鉴官方的Pool, 尝试自己实现一下最简单的Multiprocessing Pool

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45

#!/usr/bin/env python # -*- coding: utf-8 -*- from threading import Thread from Queue import Queue import time def hello(msg=None): print time.time(),msg time.sleep(5) class MPool(object): def posttask(self,func): def inner(*args, **kwargs): q = args[0] real_args = args[1:] func(*real_args, **kwargs) q.task_done() return inner def __init__(self): self._queue = Queue() #简单起见没有设置队列上限 def run_task(self, target, *args, **kwargs): task = Thread(target=self.posttask(target), args=(self._queue,)+args, kwargs=kwargs) self._queue.put(task) task.setDaemon(True) task.start() def join(self): self._queue.join() def main(): p = MPool() for i in range(10): p.run_task(hello,i) p.join() if __name__ == '__main__': main()

最后再提一下, 我的初衷只是想等所有线程结束后再退出. 默认就是这样的, join什么的都不用.